Дата публикации:Sat, 12 Jul 2025 10:59:58 +0300

Исследовательская группа METR (Model Evaluation & Threat Research) опубликовала результаты эксперимента по оценке эффективности применения AI-инструментов для написания кода. Вопреки ожиданиям, исследование показало, что AI-помощники не ускоряют, а замедляют решение поставленных задач, при том, что субъективно участники эксперимента считали, что AI ускорил их работу.

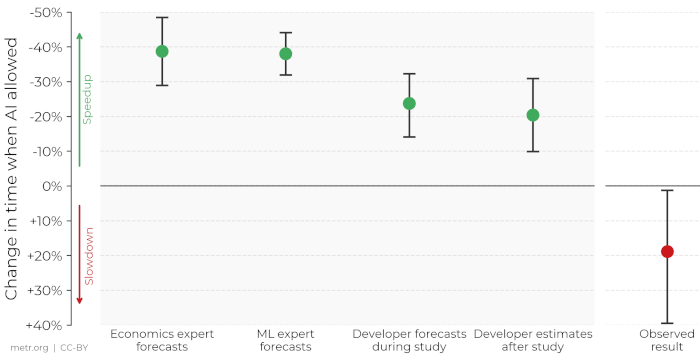

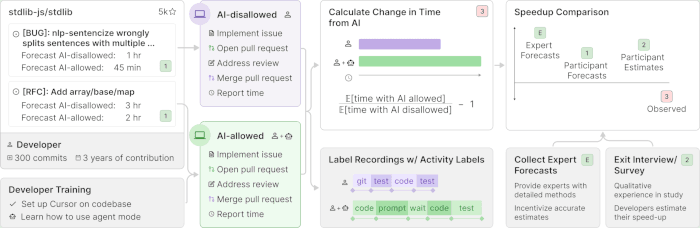

Фактически при использовании AI-помощника на решение задачи в среднем было потрачено на 19% больше времени, в то время как участники полагали, что благодаря AI смогли выполнить работу на 20% быстрее, а до начала работы считали, что AI поможет им ускорить работу на 24%. Результаты также значительно расходятся с прогнозами экспертов в области экономики и машинного обучения, которые предсказывали экономию времени при использовании AI на 39% и 38%, соответственно. В ходе эксперимента 16 разработчикам открытых проектов, имеющим средний опыт работы с AI-инструментами, было предложено решить 246 задач, связанных с исправлением ошибок и добавлением новых возможностей. Задачи были сформированы на основе реальных issue в GitHub-репозиториях проектов, с которыми у выбранных разработчиков был опыт работы не менее 5 лет. Случайным образом часть задач предлагалось решить вручную, а часть с использованием любого AI-помощника на выбор разработчика (большинство предпочли редактор кода Cursor с моделью Claude 3.5/3.7 Sonnet).

В эксперимент, который проводился с февраля по июнь 2025 года, были вовлечены такие открытые проекты, как mito, stdlib, ghc, cabal, flair, jsdom, hypothesis, trieve, scikit-learn, gpt-neox и transformers. В среднем задействованные проекты имели 23 тысячи звёзд на GitHub, 1.1 млн строк кода, 20 тысяч коммитов и 710 участников. Упоминаются следующие возможные причины замедления решения задач при использовании AI:

- Низкое качество AI-рекомендаций - разработчики приняли менее 44% от сгенерированных AI предложений и потратили много времени на их чистку и проверку. Излишний оптимизм в плане полезности AI и завышенные ожидания от возможностей AI-инструментов. Большой опыт работы участников с репозиториями, для которых решались задачи. Разработчики очень хорошо ориентировались в проектах и помощь AI в этой ситуации не представляла ценности. В эксперименте использовались слишком крупные и сложные репозитории, с которыми AI работает хуже. Неявный контекст репозитория - AI не понимал контекст, в котором работал.

Дополнительно можно отметить опрос 609 разработчиков, применяющих AI при написании кода, проведённый компанией Qodo. 78% отметили увеличение производительности труда после применения AI, 60% отметили повышение общего качества кода благодаря AI, 20% указали на снижение качества кода после применения AI. При этом 76% отметили, что они не задействуют код от AI без предварительного ручного рецензирования. В статье также отмечается, что отдельные разработчики чувствуют себя значительно лучше при использовании AI, так как могут предоставить больше кода, но ценой этого становится увеличение нагрузки на тех, кто отвечает за приём кода в проекты, рецензирование изменений и проверку качества.

Новость позаимствована с opennet.ru

Ссылка на оригинал: https://www.opennet.ru/opennews/art.shtml?num=63573